An analytics service with unlimited possibilities and unbeaten time-to-insight; this is Microsoft’s claim for Azure Synapse Analytics. Within the Synapse environment, there is an extremely high degree of flexibility and unlimited possibilities for building an exceptionally high-performance data infrastructure.

Novalytica supports organisations in building the Synapse environment and accompanies them on their journey to data-driven organisations.

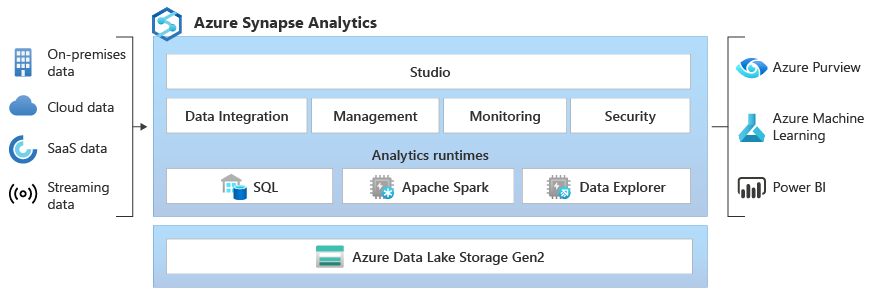

Azure Synapse Analytics combines data integration, data warehousing and (big) data analytics in a single environment. Azure Synapse Analytics is a comprehensive analytics platform that brings together a variety of industry-leading technologies to collect, explore, prepare, transform, manage and prepare data for business intelligence and analytics applications in just one interface.

Azure Synapse Analytics enables organisations to use and manage multiple data stores (SQL DB, blob storage, etc.), create and pipeline ETL (extract, transform, load) and ELT (extract, load, transform) processes by choice without code using dataflows or traditionally with code, and analyse their data in an environment that is easily accessible to different groups of users.

Azure Synapse Analytics offers the possibility to build a flexible and scalable data infrastructure that also meets increasing requirements and future application possibilities. As soon as the needs of the organisation change towards a data warehouse, Azure Synapse Analytics should be included in the evaluation. Synapse can be used as a simple DWH or as the organisation’s super-fast analytics heart with all the possibilities of modern data analysis.

Whether SMEs, large companies or public administration, with increasing digitalisation, modern organisations live with and from data. Most organisations are well positioned in the collection of data. However, there is often still great potential in the organisation of the data and the associated gain in knowledge. This potential can be fully exploited through a targeted data infrastructure.

An organisation’s data infrastructure consists of all the necessary components to collect, store, process, manage and protect its data. This includes much more than data assets and the physical infrastructure to store and process data. A data infrastructure also includes cloud resources, business applications, business intelligence and analytics tools, as well as a data strategy, policies and, in particular, staff. The right data infrastructure and the coordinated interaction of its components is a central factor for a successful data-driven digital transformation.

We work according to the principle: “As simple as possible, as complex as necessary”. Most of the time, management wants to analyse the data efficiently and interactively in a dashboard and thus make data-driven decisions. What intermediate steps are necessary in the data infrastructure to realise all the desired possibilities and evaluations?

Depending on the maturity, complexity and ambition of the organisation, the data infrastructure must be as simple as possible, but as complex as necessary. Whether a direct connection to the ERP, the step via a data lake, the construction of a data warehouse (DWH) or even the provision of specific data marts – it is important to evaluate the advantages and disadvantages and efficiently build the appropriate components.

Abhängig von der Maturität, der Komplexität und der Ambition der Organisation gilt es, die Dateninfrastruktur so einfach wie möglich, aber so komplex wie nötig zu erstellen. Ob eine direkte Anbindung an das ERP, der Schritt über einen Data Lake, den Aufbau eines Data Warehouses (DWH) oder gar die Bereitstellung von spezifischen Data Marts – es gilt die Vor- und Nachteile zu evaluieren und die passenden Komponenten effizient aufzubauen.

e support organisations as an external partner in setting up, developing, maintaining and exploiting their entire data infrastructure. We always focus on the individual requirements and strategic goals of our clients in order to generate the optimal benefit from their data through customised solutions and client-specific technologies.

In addition to our expertise in data infrastructure projects, we have broad experience in the field of analytics and can apply this knowledge when it comes to setting up a data infrastructure that meets the requirements of current or future analytics needs.

Analysis of the existing infrastructure, prerequisites and needs.

Formulating goals and use cases. Defining a roadmap.

The right choice and correct setup of data storage are central components of a data infrastructure project.

Building ETL pipelines (extract, transform, load). Ensuring and improving data quality.

Guidelines on the availability, usability, integrity and security of data for the efficient use of the data infrastructure.

Based on the data infrastructure, data can be analysed efficiently and reliably with the necessary expertise.